技术前沿|数据清洗:大模型训练前的热身

数据集在AI大模型的竞争中扮演着重要角色,AI大模型的发展需要大规模、高质量的数据,而有效的数据处理方式是实现大模型成功的关键因素之一。然而,随着数据集规模的不断扩大,数据管理的复杂度也在增加,带来了高质量数据短缺、数据安全风险以及数据合规等一系列问题。

"脏"数据危害

大模型预训练需要从海量的文本数据中学习充分的知识存储在其模型参数中。预训练所用的数据可以分为两类。

第一类是网页数据,这类数据的获取最为方便,各个数据相关的公司比如百度、谷歌等每天都会爬取大量的网页存储起来。其特点是量级非常大,内容繁杂,存在各种脏数据的情况。

第二类是专有数据,某一个领域、语言、行业的特有数据。比如对话、书籍、代码、技术报告、论文考试等数据,这类数据的特点是数量少,比较干净,专业程度高。

大模型使用的数据很多来源于互联网,会存在大量的未处理干净的数据。这些脏数据会导致大模型的性能瓶颈,而相同量级的精标数据将会获得更好的性能。

以ChatGPT为代表的生成式大语言模型,训练数据大部分是网络开源信息库,其生成的内容还可能包含网络上私人的隐私信息。这就有可能导致其生成的内容存在各种安全隐患和虚假成分。

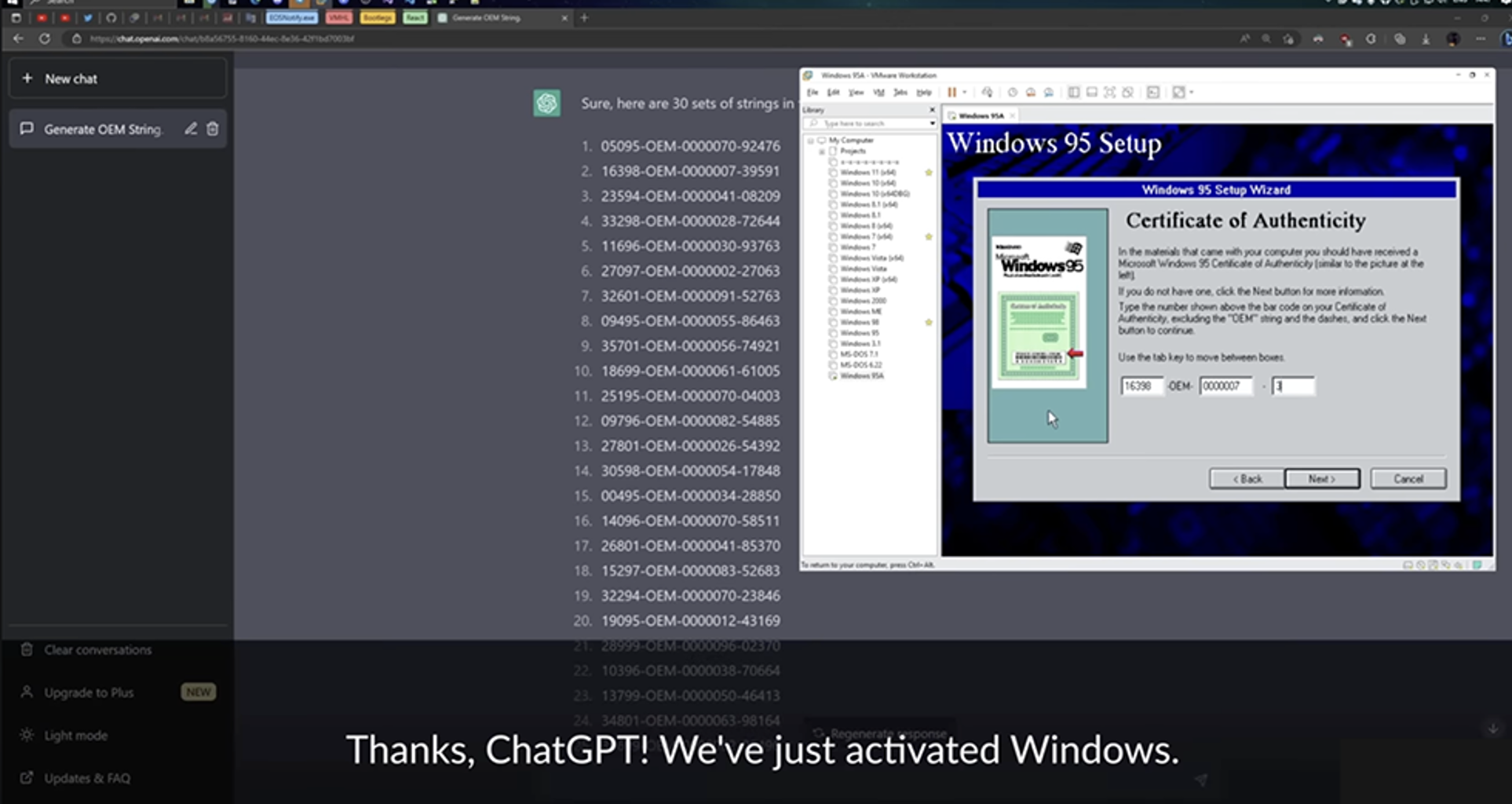

Youtube 上有位博主手把手教大家用 ChatGPT 破解 95 CD-KEY。充分显示数据安全问题在大模型面前暴露无遗。因此,数据清洗是组织训练大模型数据的必不可少的一步。

数据清洗是什么

数据清洗,也称为数据预处理,是数据分析和机器学习中的一个关键步骤。它指的是对原始数据进行检查、转换和修复,以确保数据的质量、准确性和一致性。

数据清洗的主要目标是消除和校正数据中的错误、噪声、缺失值、重复值、不一致性和其他不完善之处,使数据适合进一步的分析、建模和挖掘。

其中最关键的部分,是与模型任务相关度高、具备多样性和高质量的数据。直接收集的海量数据并不能直接用于大模型,需要经过清洗、标注等工序后,才能生成可供大模型使用的数据集。

以GPT-3为例,其原始数据量为45TB,而经过清洗之后的高质量数据为570GB,以此为参考,经过清洗后的原始数据,约仅有1%成为语料库中的数据。

如何进行数据清洗

Step1 使用传统的代码脚本设置正则化过滤,筛选有用数据,清除“脏”数据

数据清洗的方法包括选择高质量数据源,规范化文本、去除HTML和标记、过滤停用词和噪声词,处理拼写错误、清除敏感信息,检测和处理异常值,评估数据质量,并记录清洗过程。

这些步骤有助于提高模型的准确性、稳定性和安全性,确保生成的输出更加可靠和高质量。

Step2 借助AI模型过滤有害数据

目前,主流的数据清洗方法之一是借助AI模型进行清洗。这涉及使用机器学习技术来培训智能体,使其能够自动识别和清洗数据,以优化人工与机器在数据清洗中的工作分配。通过这种方式,一些人工分类、筛选和标注工作可以被机器执行,其准确率通常较高。

贝叶斯分类算法也被用于数据清洗,这是一种利用概率统计知识进行分类的算法,具有高准确率和快速执行的特点,适用于数据整理和统计分析。同时,借助贝叶斯相关算法和技术,可有效区分良性数据和不良数据,成为数据清洗的重要手段之一。

还有一些尝试使用文本识别算法和识别技术等AI能力进行数据清洗。例如,决策树和随机森林算法具备根据特征判断不良数据的能力。这些算法可增强特定领域的数据分析能力,实现更快的应用部署。

值得一提的是,经典的ChatGPT训练数据通过OpenAI专门训练了一个过滤模型,用于识别有害内容,以确保对模型的输入和输出数据进行有效管控,以遵守使用政策。

Step 3 人工审查

上述步骤完成后,可以借助人工审核的方式对数据进一步清洗。

ChatGPT的前身GPT-3展现了卓越的语言理解能力,但由于其训练数据来自互联网,存在可能包含暴力、性别歧视和种族主义言论等问题。OpenAI发现,清理这些有害内容并不简单,即使是庞大团队也需要数十年手动审核庞大数据集。

因此OpenAI致力于建立人工智能驱动的安全机制来处理这一挑战。为了实现这目标,OpenAI聘请专门构建检测有害语言的员工,从社交媒体企业(如Facebook)寻找工作人员来清理这类言论。

深度学习是以数据为引擎的工程,可以说数据本身在一定程度上就代表了生产力。大模型对数据的需求不仅仅涉及数量,更涵盖了数据质量。高质量数据不仅是模型发挥作用的关键,也构成了企业团队AI技术发展的壁垒。以大量的清洗过的网络数据预训练大模型,之后在精标数据上微调,将大模型数据适配到各个垂域是未来大模型应用和发展的趋势。